ТОР 5 статей:

Методические подходы к анализу финансового состояния предприятия

Проблема периодизации русской литературы ХХ века. Краткая характеристика второй половины ХХ века

Характеристика шлифовальных кругов и ее маркировка

Служебные части речи. Предлог. Союз. Частицы

КАТЕГОРИИ:

- Археология

- Архитектура

- Астрономия

- Аудит

- Биология

- Ботаника

- Бухгалтерский учёт

- Войное дело

- Генетика

- География

- Геология

- Дизайн

- Искусство

- История

- Кино

- Кулинария

- Культура

- Литература

- Математика

- Медицина

- Металлургия

- Мифология

- Музыка

- Психология

- Религия

- Спорт

- Строительство

- Техника

- Транспорт

- Туризм

- Усадьба

- Физика

- Фотография

- Химия

- Экология

- Электричество

- Электроника

- Энергетика

Возникновение и этапы становления информационных технологий 2 страница

Рис. 1.2. Информационная структура системы управления16

1.3. КОЛИЧЕСТВЕННЫЕ И КАЧЕСТВЕННЫЕХАРАКТЕРИСТИКИ ИНФОРМАЦИИ

В процессе отражения между состояниями взаимодействующихобъектов возникает определенная связь. Информация как результат отражения одного объекта другим выявляет степень соответствия их состояний, а поэтому важными оказываются именно количественные характеристики информации. Некоторое количествоинформации можно рассматривать с трех основных точек зрения:

• с поведенческой точки зрения создание порции информацииосуществляется по некоторой причине, а получение этой информации может привести к некоторому результату (наблюдаемому действию или мыслительной операции);

• с математиколингвистической точки зрения порция информации может быть описана путем соотнесения ее с другой информацией, указания ее смысла и структуры;

• с физикотехнической точки зрения рассматриваются физические аспекты проявления информации — ее материальный носитель, разрешающая способность и точность, с которыми она фиксируется, количество информации, которое производится, передается или принимается и т.д.

Возможен ряд подходов к оценке качества информации. Наиболее существенными из них являются статистический, семантический и прагматический. Наибольшее развитие получил первыйподход.

Статистический подход представлен в обширном разделе кибернетики — теории информации, которая занимается математическим описанием и оценкой методов передачи, хранения, извлечения и классификации информации. Теория информации в математической основе использует методы теории вероятности, математической статистики, линейной алгебры и др. В статистической теории основное внимание обращается на распределение вероятностипоявления отдельных событий и построение на его основе обобщенных характеристик, позволяющих оценить количество информации в одном событии либо в их совокупности. Количественноймерой информации стала энтропия. Чтобы возник процесс передачи, должны иметь место источник информации и потребитель. Источник выдает сообщение, потребитель, принимая сообщение,принимает при этом информацию о состоянии источника. В статистической теории, как указывалось выше, не изучают содержаниеинформации. Предполагается, что до получения информации имела место некоторая неопределенность. С получением информации

¶эта неопределенность снимается. Таким образом, статистическаяколичественная характеристика информации — это мера снимаемой в процессе получения информации неопределенностисистемы. Естественно, что количество информации зависит от закона распределения состояний системы.

Семантический подход базируется на смысловом содержанииинформации. Термин «семантика» исторически применялся в металогике и семиотике. В металогике под семантикой понимаютизучение связей между знакосочетаниями, входящими в состав какоголибо формализованного языка, и их интерпретациями (истолкованиями) в терминах той системы понятий и представлений,формализацией которой служит данный язык. В более узком смысле под семантикой подразумевают совокупность правил соответствия между формальными выражениями и их интерпретацией. Подсемиотикой понимают комплекс научных теорий, изучающихсвойства знаковых систем, т.е. систем конкретных или абстрактныхобъектов, с каждым из которых сопоставлено некоторое значение.Примерами знаковых систем являются естественные языки, а также искусственные языки, такие как алгоритмические языки, языкипрограммирования, информационные языки и др.

Прагматический подход к информации базируется на анализеее ценности, с точки зрения потребителя. Например, информация,имеющая несомненную ценность для биолога, будет иметь ценность, близкую к нулевой, для программиста. Ценность информации связывают со временем, поскольку с течением времени онастареет и ценность ее, а, следовательно, и «количество» уменьшается. Таким образом, прагматический подход оценивает содержательный аспект информации. Он имеет особое значение при использовании информации для управления, поскольку ее количество тесносвязано с эффективностью управления в системе.

Разные подходы к оценке количества информации заставляют,с одной стороны, использовать разнотипные единицы информациидля характеристики различных информационных процессов, а сдругой стороны — увязывать эти единицы между собой как на логическом, так и на физическом уровнях. Например, процесс передачи информации, измеряемой в одних единицах, сопрягается спроцессом хранения, когда она измеряется в других единицах, ит.д., а поэтому выбор единицы информации является весьмаактуальной задачей.

Рассмотрим статистическую меру количества информации,получившую наибольшее применение в процессе передачи сообщений.

Чтобы возник процесс передачи, должны существовать источник информации и потребитель. Источник выдает сообщение, потребитель, принимая сообщение, получает при этом информациюо состоянии источника. В статистической теории, как указывалосьвыше, не изучается содержание информации. Предполагается, чтодо получения информации имела место некоторая неопределенность. С получением информации эта неопределенность снимается. Таким образом, статистическая количественная характеристикаинформации — это мера, на основе которой в процессе полученияинформации снимается неопределенность системы. Естественно,что количество информации зависит от закона распределения состояний системы.

Введем количественную меру информации для простейшего варианта передачи равновероятных сообщений. Пусть источник формирует М сообщений, каждое из которых передается неизбыточным кодом длиной п. Определим число сведений/в некотором сообщении, полагая, что оно линейно зависит от длины кода, т.е.f=kn, где k — коэффициент пропорциональности. Будем считатьчто выполняются следующие условия: осуществляется передачадискретных сообщений; сообщения являются равновероятными ивзаимонезависимыми; символы, выдаваемые источником, взаимонезависимы; система счисления (основание кода) К конечна. Тогдачисло передаваемых сообщений составляет М = К1. Учитывая, что/=*и, получаем d/= kdn, dM = A" In Kdn, dn = сШ/Пп К,df = kdM/M\nk.

Отсюда

где ko = ki/ln К; ki = k Ina.

За единицу количества информации примем число сведений,которые передаются двумя равновероятными сообщениями. Назовем эту единицу двоичной единицей информации. Тогда для/= 1,М=2 получим /= *6 log,, 2. Отсюда а = 2, ko = 1 и, следовательно,количество информации в сообщении составит /=log2M

Эта формула получила название формулы Хартли. Из нее слеДУет, что для равновероятных дискретных сообщений количествоинформации зависит лишь от числа передаваемых сообщений.

Если сообщения отображаются неизбыточным кодом, то, подставляя М= К", получим /= п Iog2 К.

Видно, что число двоичных единиц информации, содержащихся в одном сообщении, прямо пропорционально длине кода п и

¶возрастает с увеличением его основания. Если основание кодаК= 2, то количество информации, содержащееся в любом сообщении, передаваемом неизбыточным кодом, составит /= п двоичныхединиц или бит. Отсюда видно, что если длина сообщения равна п,то сообщение содержит п бит информации, т.е. один элемент коданесет одну двоичную единицу информации. Информация, содержащаяся в сообщении, складывается из информации, которую несет каждый элемент кода, поэтому мера информации является аддитивной.

Аддитивность статистической меры информации позволяет определить ее количество и в более общем случае, когда передаваемые дискретные сообщения являются неравновероятными. Можнопредположить, что количество информации, содержащейся в конкретном дискретном сообщении, функционально зависит от вероятности выбора этого сообщения. Тогда для сообщения xq/ возникающего с вероятностью /Xxq/), количество информации можетбыть описано в виде 1= ср [Р (.%)]. Пусть вслед за сообщением xq/ изисточника формируется сообщение хо*. Вероятность последовательного возникновения этих сообщений обозначим Р(хщ, xjK). Количество информации, которая будет содержаться в этих сообщениях, оценим как 1 = ф [P(xq/, xok)] Учитывая аддитивный характерпринятой выше статистической меры информации, будем считать,что количество информации, заключенное в последовательностисообщений XQJ, хоь равно сумме количеств информации, содержащихся в каждом из выбранных сообщений. Тогда

где Р (XQ/C/XQJ) — вероятность возникновения сообщения хь* при условии появления перед ним сообщения XQ/.

Соответственно вероятность возникновения последовательности сообщений XQ/, XOK составит Дхо/, хад) = Л%) [Р CW*o/) • Отсюда

Дифференцируя по переменной P(XQJ), получим

Умножим левую и правую части уравнения на вероятностьP(XOJ), тогда

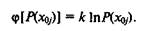

Учитывая, что вероятность Дхо,) находится в пределах от 0 до 1,видим, что части уравнения должны представлять собой постоянную величину, т.е. P(XQJ) q>' [P(xoj)] ~ k, где k — постоянная величина. Отсюда ф' [P(xoj)] = k/P(xoj). Количество информации в у'м сообщении составит

где с — постоянная интегрирования. Для определения с рассмотрим частный случай, когда имеет место передача лишь одного у'госообщения, т.е. P(xq/) = 1. Подставляя Дхо,) = 1 в приведенноеуравнение, находим, что с = 0, а отсюда

Для определения постоянной k выберем систему единиц. Естественным требованием является то, что количество информациидолжно быть положительной величиной, тогда, принимая k = 1,получаем

Тогда в качестве единицы информации можно принять натуральную единицу. Количество информации в одну натуральную единицу (1 нат) равно информации, которая передается в одном сообщении с вероятностью появления 1/е. Как указывалось выше, в статистической теории получила применение двоичная единица информации, что соответствует коэффициенту k = 1/ln 2. Тогда количество информации для неравновероятных сообщений составит

При необходимости количество информации в случайно выбранном сообщении нетрудно связать с информативностью символов кода сообщения. Если процесс образования символов описывается цепью Маркова и символы могут принимать К значений, тонайти вероятность возникновения сообщения P(XQJ) можно какпроизведение вероятностей возникновения символов его кода.Если они выбираются независимо и символ типа j встречается л/раз, то вероятность возникновения сообщения XQ/ составит

где P(xj) — вероятность возникновения символа типа j.

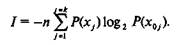

¶При большой длине кода п можно считать, что л, = nP(xJ), а таккак выше установлено, что количество сообщения.% составляет/ = Iog2 Р(ху), то, подставляя полученные выше значения вероятности РС%), найдем количество информации / в виде

Видно, что количество информации прямо пропорциональнодлине кода п и информативности отдельно взятого символа. Отметим, что максимально возможное количество информации, т.е.максимум записанного выше выражения, получается, если символы равновероятны. Тогда для множества символов К оптимальноеравномерное распределение соответствует Р(х}) = \/К. В этом случае получим, что / = п lo&K. Для двоичного кода К = 2, I = п, чтосоответствует количеству информации для неизбыточного кода приравновероятных сообщениях. Введенная количественная статистическая мера информации широко используется в теории информации для оценки количества собственной, условной, взаимной идругих видов информации. Рассмотрим это на примере собственной информации.

Под этим будем понимать информацию, которая содержится вданном конкретном сообщении. В соответствии с этим определением количество собственной информации в сообщении XQ/ определяется как /(jcq/) = Iog2/)(xq/). Количество собственной информации измеряется числом бит информации, содержащихся в сообщении xoj. Для нее могут быть сформулированы следующиесвойства:

1. Собственная информация неотрицательна. Чем меньше вероятность возникновения сообщения, тем больше количество информации, содержащейся в нем. Если сообщение имеет вероятностьвозникновения, равную единице, то получаемая с ним информация равна нулю, так как заранее известно, что может прийти только это сообщение, и выявление данного сообщения не несет потребителю никакой информации.

2. Собственная информация обладает свойством аддитивности.Для доказательства этого рассмотрим ансамбль из множества сообщений {Л', У}. Найдем количество собственной информации дляпары сообщений JCQ,, y0i:

22

Если сообщения хщ, Уы статистически независимы, тоP(XOJ, yai) = P(XOI) f(yoi) Количество информации в двух сообщенияхсоставит

Таким образом, количество собственной информации в двухнезависимых сообщениях равно сумме собственных сообщений.Отметим, что она характеризует сообщение, которое возникаетслучайным образом из источника, а поэтому является случайнойвеличиной и зависит от номера выбранного сообщения.

Рассмотрим понятия и свойства энтропии дискретных систем.Математическое ожидание случайной величины собственной информации называется энтропией. Энтропия рассчитывается намножестве (ансамбле) сообщений XQ либо на множестве символовХи физически определяет среднее количество собственной информации, которое содержится в элементах множества (либо сообщений, либо символов). Для источника сообщений случайная величина собственной информации принимает значения /(лш), ф^), •••>1(х<у),..., 1(хоМ) с вероятностями Дхш), Р(х^г),..., Цхц),..., Р(хои) соответственно.

Среднее количество (математическое ожидание) собственнойинформации, содержащейся в ансамбле сообщений Х0, т.е. энтропия этого ансамбля, составит

где М— множество сообщений в ансамбле XQ. Содержательно энтропия ЩХ0) показывает количество двоичных единиц информации, которая содержится в любом сообщении из множества XQ.

Следует отметить, что понятие энтропии исторически использовалось для оценки меры неопределенности состояния любойсистемы. Чем больше энтропия системы, тем больше неопределенность ее состояния и тем большую информацию получаем, когдаэта неопределенность снимается. Энтропия как количественнаямера информации обладает следующими свойствами [48]:

1. Функция энтропии является непрерывной относительно вероятности возникновения событий и для дискретных событий имеет наибольшее значение при равной вероятности их появления.Если возможно появление лишь одного события, то априорной неопределенности нет, поэтому количество информации и энтропияравны нулю;

¶2. При равновероятных событиях функция энтропии возрастаетс увеличением числа событий в ансамбле, а поэтому для повышения информативности символов необходимо увеличивать основание системы счисления используемого кода;

3. Функция энтропии не зависит от пути выбора событий. Этосвойство вытекает из аддитивности статической меры информациии, как следствие, аддитивности функции энтропии;

Теперь перейдем к понятиям «энтропия источника» и «энтропия сообщения». При кодировании важно обеспечить выбор кода,который оптимально согласуется с источником. Это согласованиевозможно по критерию энтропии источника. Под энтропией источника обычно понимают количество информации, которая всреднем содержится в одном символе кода. Если код имеет основание системы счисления К, то энтропия источника, т.е. среднее количество информации, содержащейся в символе кода, составит

Содержательно энтропия источника показывает, сколько двоичных единиц информации переносится в среднем в одном символе кода. Для повышения информативности источника необходимостремиться к равновероятности символов. В этом случае для неизбыточного кода в одном символе передается двоичная единица информации. С введением избыточности информативность символауменьшается, но появляются возможности, связанные с обнаружением и исправлением ошибок, что обеспечивает требуемую помехоустойчивость передачи сообщений. Среднее количество информации, содержащееся в сообщении, называется энтропией сообщения и определяется в виде

Видно, что энтропия сообщения представляет собой математическое ожидание собственной информации, содержащейся в ансамбле сообщений АО. Таким образом, энтропия является универсальной статистической характеристикой, позволяющей оценитьколичество информации, которая содержится в любом ансамбледискретных событий.

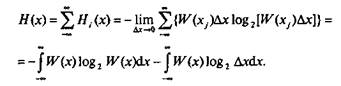

Понятие энтропии применимо и к непрерывным событиям. Всистемах обработки информации и управления значительная доляинформации имеет непрерывный характер и выражается в виде не

прерывной функции от времени. В этом случае возникает задачапередачи непрерывной информации в виде непрерывных сообщений по каналам связи. Непосредственная передача непрерывныхсообщений без преобразования возможна лишь на незначительныерасстояния. С увеличением расстояний осуществляют операциюдискретизации информации. Для этого вводят квантование по времени и по уровню. Непрерывная функция передается в виде совокупности мгновенных либо квантовых отсчетов, выбранных с различными интервалами по времени. Оценим количество информации, которая содержится в одном отсчете непрерывной функции, инайдем общее выражение для энтропии непрерывных событий.

Пусть имеет место непрерывная информация, представленная ввиде непрерывной функции x(t) с известной плотностью распределения вероятностей амплитудных значений Щх). Разобьем областьзначений функции на К уровней с интервалом квантования Ах, тогда получим уровни х\, хг,..., х/,..., хк. При достижении функциейx(t) некоторого уровня Xj и передаче этого уровня по каналу связиколичество передаваемой информации может быть определено спомощью функции энтропии H(XJ), если известна вероятность возникновения отсчета P(xJ). Для нахождения вероятности P(XJ) построим плотность распределения Щх) и отметим отсчеты функций

х;+Дх/2

х\, Х2,..., Xj, (рис. 1.3). Вероятность P(xj) = \ W(x)dx отображена

хуЛх/2

заштрихованной на рис. 1.3 площадью под кривой Щх). Для упрощения расчетов заменим эту площадь другой площадью эквивалентного прямоугольника с основанием Дх и высотой Щх/), тогдавероятность Дх,) = Щх/)Ьх. Отсюда количество собственной информации, содержащейся в отсчете х/, составит

Рис. 1.3. Зависимость плотности распределения вероятностей Щх) от уровня амплитуды х

¶Энтропия отсчета определяет количество информации, котораяпередается отсчетом функции xj. С уменьшением шага дискретизации Ал, т.е. при Лх> О, можно найти lim Я(х,), т.е. предварительное значение

Учитывая, что исходная функция x(f) непрерывна и может изменяться в неограниченных пределах, найдем энтропию непрерывного сообщения как сумму энтропии отсчетов в виде

Второе слагаемое содержит член Iog2 Ax, который не рассчитывается, так как с уменьшением Ах он может стать бесконечно большой величиной. Обычно определяют так называемую дифференциальную или приведенную энтропию в виде

Таким образом, понятие энтропии применимо и для оценкисреднего количества информации, которая содержится в непрерывном сообщении. Однако пользоваться выражением энтропии длянепрерывных сообщений следует крайне осторожно, учитывая неопределенность второго слагаемого выражения, особенно при малых значениях шага квантования Ах.

В целом в отношении энтропии непрерывного сообщения можно сделать следующие выводы:

1. Дифференциальная энтропия определяется статистикой отсчетов непрерывной функции. Можно показать, что при постоянной дисперсии отсчетов наибольшее количество информации соответствует непрерывным сообщениям, отсчеты которых распределяются по нормальному закону;

2. Энтропия зависит от амплитуды исходной непрерывнойфункции х и шага ее квантования Ах. На практике реализуют системы с равномерным и неравномерным шагом квантования, с передачей отклонения функции от математического ожидания и др.

Это позволяет в конкретных условиях повысить скорость передачиинформации в непрерывном канале.

Таким образом, статистическая теория позволяет дать плодотворные оценки количества информации для такого важного этапаинформационного процесса в системе, как передача. Заложенныееще К. Шенноном принципы количественной оценки на основефункции энтропии сохраняют свою значимость до настоящего времени и являются полезными при определении информативностисимволов и сообщений и при оценке оптимальности построениякода на основе критериев избыточности.

В современных системах обработки информации и управлениясущественное место занимает подготовка информации для принятия решения и сам процесс принятия решения в системе. Здесь существенную помощь может оказать семантическая теория, позволяющая понять смысл и содержание информации, выражаемой наестественном языке. С увеличением объема и сложности производства количество информации, необходимое для принятия безошибочного решения, непрерывно возрастает. В этих условиях необходимо осуществлять отбор информации по некоторым критериям,т.е. предоставлять руководителю либо лицу, принимающему решение, своевременную и полезную информацию. С учетом ошибок,которые могут возникать в информации в связи с действиями оператора, отказами технических средств в др., избыточность допускается лишь как средство борьбы с ошибками. В этом смысле можносчитать, что избыточность способствует сохранению ценности информации, обеспечивая требуемую верность. В рамках семантического подхода ценность информации можно задать через функциюпотерь. Если в процессе подготовки информации исходная величина х отображается через величину у, то минимум потерь можно установить как

где Р(х) — распределение входной величины х; П(х/у) — потерипри преобразовании входной величины х в величину у.Отсюда ценность информации определяется как

где М{П(х/у)} — математическое ожидание потерь при отклоненииот входной величины х к величине у.

¶Следует отметить, что данная интерпретация ценности имеетсугубо технический характер. Конструктивным выходом из нее является такое разбиение входной величины х, при котором удаетсямаксимизировать ценность. В общем случае ценность информации, поступающей от материального объекта, является функциейвремени. Анализ информации, используемой для принятия решения в реальных системах, позволил найти функции ценности. Этифункции задают предельные временные интервалы, в течение которых имеет смысл использовать данную информацию. При принятии решения обычно используется информация не только оматериальном объекте, но и об условных распределениях критериальных оценок последствий различных альтернативных решений. Вэтом случае резко уменьшается число предпочтительных альтернатив и удается принять решение, базируясь на качественно неполной информации. В ряде практических случаев решение принимается с использованием субъективных критериев, при этом приходится применять большой объем информации, ужесточать требования к согласованности и непротиворечивости исходной информации. Принцип принятия решений по своей методологии требуетсохранения содержания качественных понятий на всех этапах использования информации при общей оценке альтернативных решений. Кроме того, исключается сложная информация, при работес которой лицо, принимающее решение, должно иметь дело с громоздкими задачами. Используют замкнутые процедуры выявленияпредпочтений, т.е. процедуры, в которых имеется возможностьпроверить предпочтение на непротиворечивость и транзитивность.Можно отметить, что семантическая теория требует дальнейшейсерьезной проработки, однако уже сейчас при принятии решенийсуществует ряд методов, позволяющих оценивать смысловое содержание информации.

1.4. ПРЕВРАЩЕНИЕ ИНФОРМАЦИИ В РЕСУРС

Обеспечение любого вида деятельности составляют финансы,материальные ресурсы, штаты и информационные ресурсы.

Если первые три вида ресурсов можно рассматривать обособленно, то информационные ресурсы тесно взаимосвязаны с каждым из них и по уровню иерархии стоят выше, так как используются при управлении остальными.

Информацию как вид ресурса можно создавать, передавать, искать, принимать, копировать (в той или иной форме), обрабатывать, разрушать. Информационные образы могут создаваться в самых разнообразных формах: в форме световых, звуковых или радиоволн, электрического тока или напряжения, магнитных полей,знаков на бумажных носителях. Важность информации как экономической категории составляет одну из главнейших характеристикпостиндустриальной эпохи.

Информационный ресурс — концентрация имеющихся фактов, документов, данных и знаний, отражающих реальное изменяющееся вовремени состояние общества, и используемых при подготовке кадров,в научных исследованиях и материальном производстве [14, 37].

Факты — результат наблюдения за состоянием предметной области.

Документы — часть информации, определенным образом структурированная и занесенная на бумажный носитель.

Данные — вид информации, отличающийся высокой степеньюформатированности в отличие от более свободных структур, характерных для речевой, текстовой и визуальной информации.

Знания — итог теоретической и практической деятельности человека, отражающий накопление предыдущего опыта и отличающийся высокой степенью структурированности.

Можно выделить три основных вида знаний:

• декларативные (факторальные), представляющие общее описание объекта, что не позволяет использовать их без предварительной структуризации в конкретной предметной области;

• понятийные (системные), содержащие помимо первых, взаимосвязи между понятиями и свойства понятий;

• процедурные (алгоритмические), позволяющие получить алгоритм решения.

Контрольные вопросы

1. В чем сущность создания информационного общества?

2. Какие существуют точки зрения на понятие информации?

3. В чем заключается понятие информации?

4. Какие существуют виды иерархии информации?

5. В чем суть информационного подхода к процессу управления?

6. Чем определяются количественные характеристики информации?

7. Какие критерии используются при статистическом подходе к оценке качестваинформации?

8. В чем суть семантического подхода к оценке качества информации?

9. В чем суть прагматического подхода к оценке качества информации?

10. Чем определяются информационный ресурс и его составляющие?

¶Глава 2

Понятие информатизации. Стратегияперехода к информационному обществу

Информатизация является решающим фактором развития современного общества, обеспечивающим соответствующий уровеньжизни всех его членов на основе использования технологий высокого уровня Развитие человечества привело к необходимости переходаот индустриального к информационному обществу, для которого характерно обеспечение требуемой степени информированности всехего членов и предоставление возрастающего объема информационных услуг высокого уровня. Степень перехода к информационномуобществу предлагается оценивать по совокупности признаков, средикоторых определяющими являются: уровень информационных потребностей населения, информационная культура, степень информатизации экономики, лидирующая роль образования, вхождение вмировое информационное пространство. Рассматриваются основные этапы перехода, соответствующие им стратегические цели информатизации, пути устранения возникающих противоречий.

2.1. ЭТАПЫ ЭВОЛЮЦИИ ОБЩЕСТВАИ ИНФОРМАТИЗАЦИИ

Завершается век энергетики и на его смену в соответствии спрогнозом Н.Винера приходит век информатики. Первый век текущего тысячелетия войдет в историю человечества как век завершения перехода из индустриального общества в общество информационное. Процесс перехода, получивший название информатизации, интенсивно реализуется во всех странах мирового сообщества. На этот путь достаточно давно вступила и Россия. Прогнозыученых позволяют утверждать, что большинство западноевропейских стран и с некоторым отставанием и Россия не позднее середины будущего столетия перейдут в информационное общество.Исчерпывающей характеристики информационного обществапока не существует, но предполагают, что в таком обществе будут

Не нашли, что искали? Воспользуйтесь поиском: